本文提出基于对抗学习的策略来进行知识蒸馏,定义逐级训练损失来指导和优化预定义的学生网络以回复教师模型中的知识,并使判别器网络同时区分老师和学生特征。

简介

来源:

- 神经网络中包含冗余信息(知识)

- 整体神经网络较大且训练慢

提出:

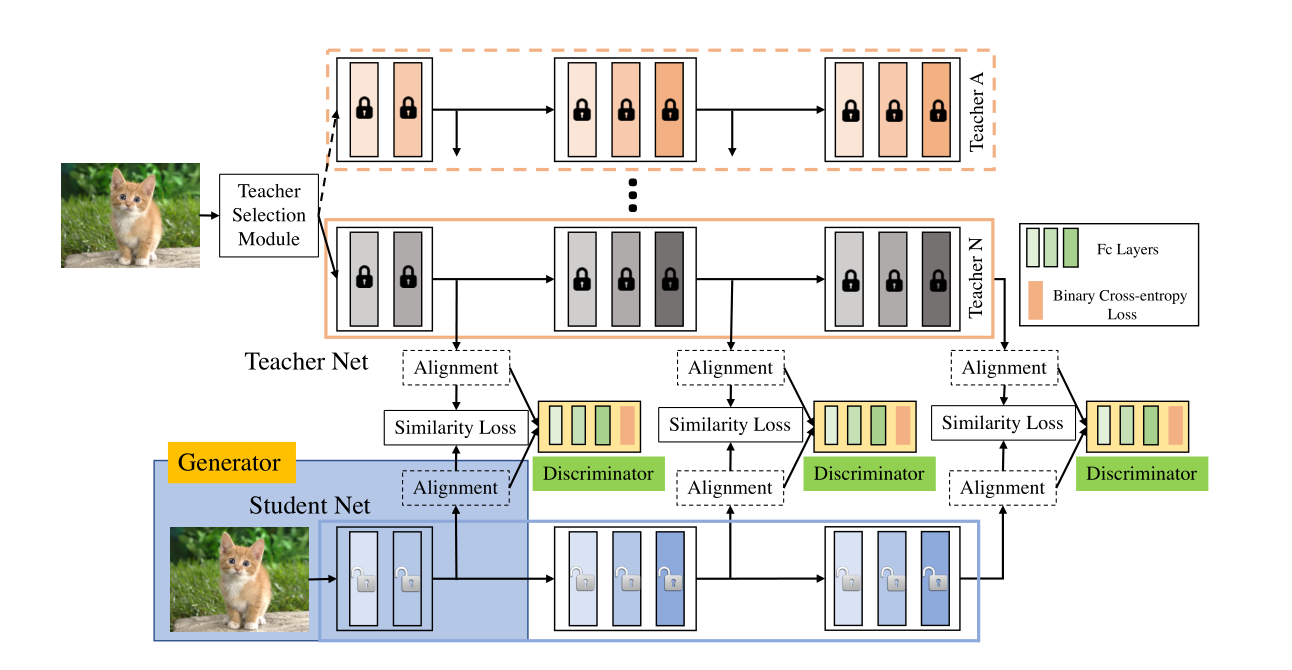

基于学习的集成方法。即,学习多个神经网络的集成,而不会产生任何额外的测试成本。

利用不同神经网络输出集合作为监督训练目标网络。

网络介绍

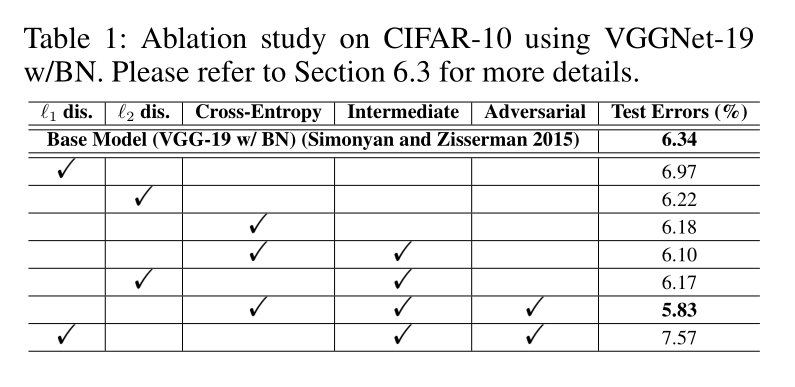

三种计算teacher与student中间block损失的方法

- L1 Loss

- L2 Loss

- KL 散度

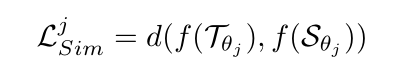

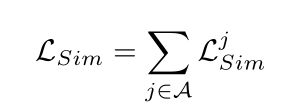

中间block对齐方式采用自适应池化,损失计算方式为:

其中,d表示以上三种损失计算方法之一。

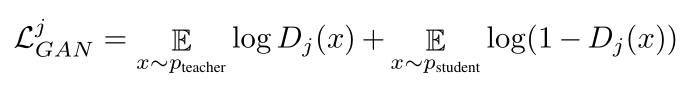

中间block discriminator损失计算方式:

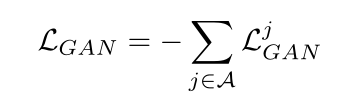

总体discriminator损失:

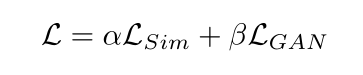

网络总体损失:

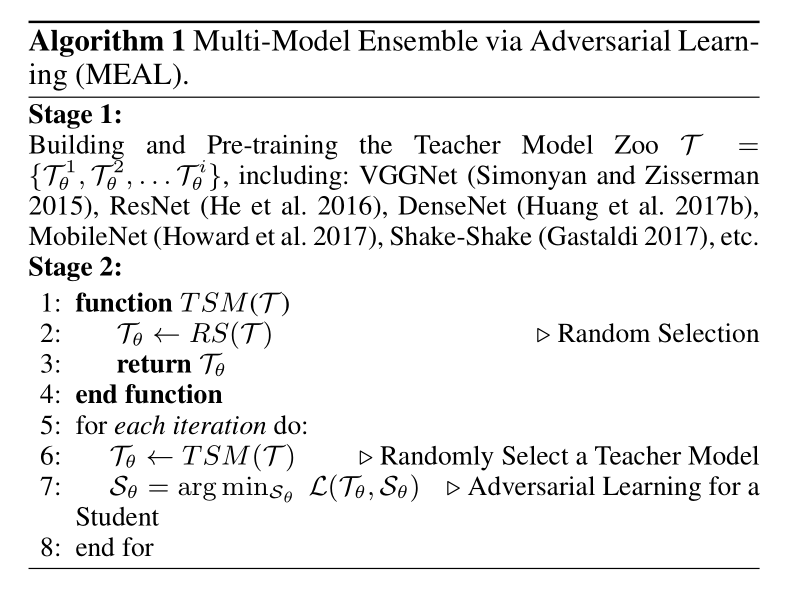

整体算法流程

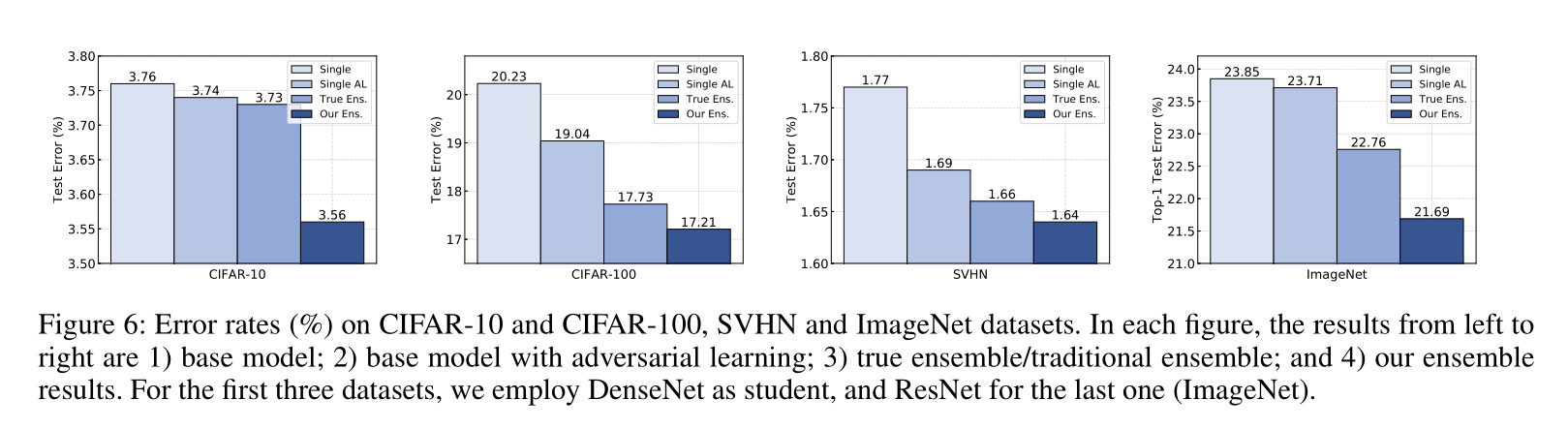

结果